변동계수(변이계수, coefficient of variation, CV)는 평균에 대한 표준편차의 비입니다. 일반적으로 양의 실수인 표준편차와 더불어 평균을 양의 실수로 하여 변동계수를 양의 실수로 정의하는 것이 일반적입니다.

$$\text{변동계수}=\dfrac {\text{표준편차}}{\text{평균}}$$

변동계수의 정의식에서 분모인 평균은 값이 0이 아니여야 합니다. 분모인 평균의 단위는 분자인 표준편차의 단위와 같습니다. 따라서 변동계수는 단위가 없는 수인 무차원수(dimensionless number)입니다. 그러므로 변동계수는 단위가 다른 집단의 속성이나 확률변수를 비교하는 경우에 유용합니다.

변동계수는 평균과 표준편차간의 계수(coefficient)라고도 할 수 있습니다.

$$\text{평균}=\text{변동계수}\times \text{표준편차}$$

모집단의 변동계수는 모표준편차($\sigma$)의 모평균($\mu$)을 단위로 한 양입니다. 즉, 변동계수는 모표준편차를 모평균으로 나눈 것입니다.

$$CV_{\text{population}}=\dfrac {\sigma}{\mu}$$

여기서, $\sigma$는 모표준편차

$\mu$는 모평균

모집단의 변동계수는 모집단의 특성을 나타내는 상수입니다.

표본의 변동계수는 표본의 표준편차($S$)를 표본의 산술평균($\bar{X}$)으로 나눈 것입니다.

$$CV_{\text{sample}}=\dfrac {S}{\bar{X}}$$

여기서, $X$는 확률변수

$\bar{X}$는 확률변수 $X$의 표본평균

표본의 변동계수는 두 확률변수인 표본평균과 표본표준편차의 비입니다. 표본평균을 양의 실수로 정의한다면 변동계수를 새로운 확률변수로 정의할 수 있습니다.

확률변수의 변동계수는 확률분포의 평균에 대한 표준편차의 비입니다. 확률변수의 변동계수는 그 확률변수에 대응하는 모집단의 변동계수와 같습니다.

$$CV_{\text{vaiable}}=\dfrac {\sigma}{\mu}$$

표본의 변동계수는 표본의 표준편차($S$)를 표본의 산술평균($\bar{X}$)으로 나눈 것입니다.

$$CV_{\text{sample}}=\dfrac {S}{\bar{X}}$$

여기서, $X$는 확률변수

$\bar{X}$는 확률변수 $X$의 표본평균

집단의 변동의 특성을 설명하는 측도에는 변동계수가 있습니다. 집단의 변동계수(변이계수, coefficient of variation, CV)는 집단의 표준편차를 집단의 평균으로 나눈 것입니다. 따라서 집단의 변동계수는 집단의 평균에 대한 집단의 표준편차의 비입니다.

$$CV_{\text{group}}=\dfrac {\sigma_{\text{group}}}{\mu_{\text{group}}}$$

여기서, $\sigma_{\text{group}}$는 집단의 표준편차

$\mu_{\text{group}}$는 집단의 평균

집단의 변동계수는 신호(집단의 평균)에 대한 노이즈(집단의 표준편차)의 비로도 볼 수 있습니다.

한 집단(group)의 변동계수는 그 집단의 변동을 설명하는 중요한 무차원수입니다.

변동(variation)은 통계학에서 데이터가 얼마나 흩어져 있거나 퍼져 있는 지를 표현하는 용어입니다. 집단의 변동은 기준으로 부터 집단의 데이터가 얼마나 퍼져 있는 가를 나타냅니다.

집단 전체의 변동은 집단 평균의 변동과 집단내 변동으로 나눌 수 있습니다. 집단 평균의 변동은 집단 외부에 기준(예를 들면 0)이 있으며 집단내 개체의 변동은 집단의 평균을 기준으로 합니다.

정리하면 한 집단의 변동은 그 집단을 하나의 강체로 보는 “집단 강체의 변동”과 집단내 개체의 변동의 합을 나타내는 “집단내 변동”이라는 두 변동의 합이라고 볼 수 있습니다. 변동을

$$\text{집단의 전체 변동}=\text{집단 평균의 변동}+\text{집단 내 변동}$$

$$SS_T=SS_B+SS_E$$

“집단 평균의 변동”은 “집단 강체의 변동”으로 볼 수 있고 기준이 집단의 외부에 있는 경우이며 집단의 평균의 제곱과 집단의 크기의 곱으로 설명할 수 있습니다. 즉, 집단 외부에 있는 기준과 집단평균과의 거리가 크면 “집단 강체의 변동”도 크다고 할 수 있습니다. 이 변동은 집단의 평균으로 설명할 수 있습니다.

“집단내 변동”은 집단에서 구한 평균을 기준으로하는 집단내 개체의 변동의 합이라고 할 수 있습니다. 즉, “집단내 변동”은 평균과 각 데이터 포인트와의 편차를 제곱하여 모두 합한 값입니다. “집단내 변동”은 집단에 속한 개체의 수에 대한 정보도 포함하고 있습니다. 따라서, 집단에 속한 개체의 수가 많을 수록 “집단내 변동”은 커집니다. 그리고 집단에 속한 개체수가 많다는 것은 집단에 대한 정보량이 많다고도 볼 수 있습니다. 따라서 “집단내 변동”은 집단간의 상대빈도(개체의 출현확률)를 비교할 때 사용될 수 있습니다. “집단내 변동”은 집단의 개체수 외에 각 개체의 속성을 나타내는 데이터가 얼마나 집단의 평균으로부터 얼마나 떨어져 있는 지에 대한 정보도 가지고 있습니다. 개체의 속성이 정규분포를 가지는 경우, “집단내 변동”을 표준화하여 카이제곱으로 변환할 수 있습니다.

집단의 두 변동의 관계를 변동계수로 표현할 수 있습니다. 변동계수는 “집단 강체의 변동”을 나타내는 집단의 평균과 “집단내 개체의 변동”을 나타내는 집단의 표준편차의 비이기 떄문입니다. 따라서 변동계수는 “집단 강체의 변동”과 “집단 내 개체의 변동”의 크기를 비교하는 “계수”라고도 할 수 있습니다. 따라서 집단의 변동변수는 감마분포의 모양을 결정하는 매개변수인 $\theta$가 됩니다.

집단에 속한 개체수인 집단의 크기를 알면 집단의 자유도는 (집단크기-1)입니다. “집단내 변동”을 집단의 자유도로 나누어 집단의 분산을 구하고 그 분산의 제곱근으로 표준편차를 구합니다.

분산(variance)

$${\text Var}[X]={\text E}[(X-{\text E}[X])^2]$$

분산공식(variance formula)

$${\text Var}[X]={\text E}[X^2]-{\text E}[X]^2$$

분산공식(variance formula)를 변형하면

$${\text E}[X^2]={\text E}[X]^2+{\text Var}[X]$$

${\text E}[X^2]$를 상수(constant)로 보면

$${\text E}[X^2]=\mu^2+\sigma^2$$

윗식의 양변에 제곱근을 취하면

$$\sqrt{{\text E}[X^2]}=\sqrt{\mu^2+\sigma^2}$$

여기서, $\sqrt{{\text E}[X^2]}$는 집단의 제곱평균(root mean squares, RMS)

$\sigma^2$은 집단내분산

$\mu^2$은 집단평균의 제곱

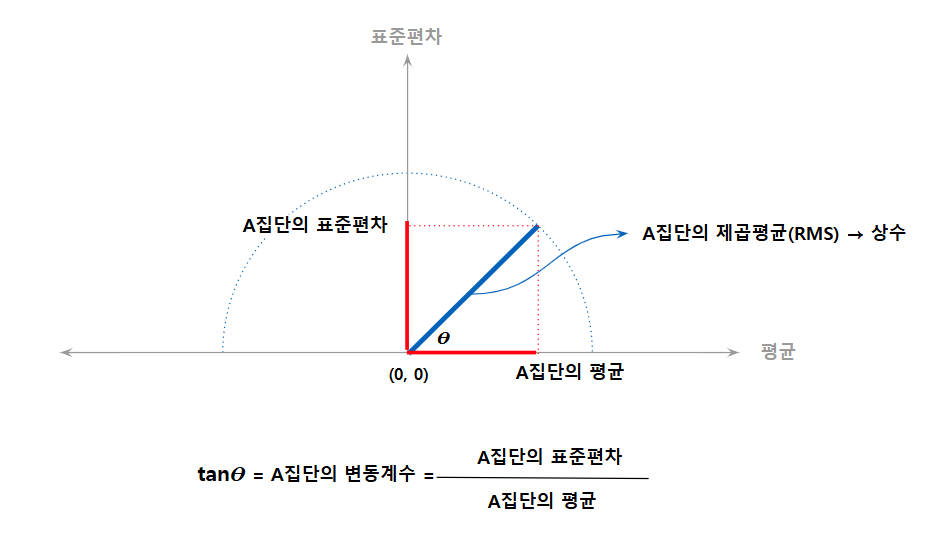

집단의 평균제곱(RMS, $\sqrt{{\text E}[X^2]}$)를 상수(constant)로 고정하면 집단의 변동계수($CV_{\text{group}}$)는 $\dfrac{\sigma_{\text{group}}}{\mu_{\text{group}}}$이기 때문에 집단의 변동계수는 집단의 평균제곱의 위상(phase)이 됩니다.

집단의 평균제곱(RMS)을 상수로 고정하면 즉, 외부로부터의 영향이 없이 평균과 표준편차가 결정된다고 하면 다음식으로 표현할 수 있습니다.

$$\text{RMS}_{\text{group}} = \sqrt{\text{E}[X^2]} = C$$

집단의 변동계수(Coefficient of Variation, \( CV_{\text{group}} \))는 다음식으로 표현할 수 있습니다.

$$CV_{\text{group}} = \frac{\sigma_{\text{group}}}{\mu_{\text{group}}}$$

표준편차와 평균제곱의 관계를 이용하면 다음과 같습니다.

$$

\sigma_{\text{group}}^2 = \text{E}[X^2] – \mu_{\text{group}}^2

$$

양변에 제곱근을 취하면 다음과 같습니다.

$$

\sigma_{\text{group}} = \sqrt{\text{E}[X^2] – \mu_{\text{group}}^2}

$$

이때 \( \text{E}[X^2] \)을 \( C^2 \)로 고정하면 다음과 같습니다.

$$

\sigma_{\text{group}} = \sqrt{C^2 – \mu_{\text{group}}^2}

$$

따라서 변동계수는 다음식으로 표현할 수 있습니다.

$$

CV_{\text{group}} = \frac{\sqrt{C^2 – \mu_{\text{group}}^2}}{\mu_{\text{group}}}

$$

이를 변형하면,

$$

CV_{\text{group}} = \sqrt{\frac{C^2}{\mu_{\text{group}}^2} – 1}

$$

즉, 집단의 변동계수는 집단의 평균제곱(\( C^2 \))의 위상(phase) 역할을 합니다.

변동계수는 얼마나 소비자가 딸기의 당도를 고르게 느끼는 지를 알고자 하는 경우에 사용할 수 있습니다. 소비자는 당도가 높으면 당도의 변화(변동)를 덜 느끼기 때문에 이를 고려하여 표본표준편차를 표본평균으로 나눈 변동계수로 출하시기별 딸기의 품질을 비교할 수 있습니다.

다음 동영상에서는 변동계수의 활용사례로 1. 기업성과 비교, 2. 딸기의 품질 비교를 설명하고 있습니다.

변동계수 활용사례 2 : 딸기의 품질 비교

확률과 통계에서 데이터의 평균은 보통 산술평균을 의미합니다. 산술평균 (기대값)은 중심값으로서 데이터 값의 합을 데이터 수로 나눈 값입니다. 숫자 집합 $x_1, x_2, \cdots, x_n$의 산술평균은 일반적으로 “엑스 바(X bar)”라고 발음되는 $\bar {X}$로 표시됩니다. 집단의 모평균($\mu$ 또는 $\mu_{X}$로 표시)은 “뮤”라고 발음합니다. 집단에서 추출하여 얻은 표본의 산술평균들의 분포를 집단의 표본평균 ($\bar {X}$)의 표집분포(sampling distribution)이라고 부릅니다.

확률 및 통계에서 집단의 모평균(기대값)은 확률분포 또는 그 분포로 특정되는 확률변수의 중심을 표현하는 대표적인 척도입니다. 확률변수 $X$의 이산확률분포의 경우, 평균은 그 값의 확률로 가중치화된 모든 값의 합과 동일합니다. 즉, $X$의 가능한 값 $x$와 그 확률$p(x)$의 곱을 취한 다음 이들을 모두 합하여 구합니다. $ \mu = \sum x \cdot p(x)$. 연속확률 분포의 경우에도 유사한 공식이 적용됩니다. 예를 들어, 구성원의 평균 키는 모든 구성원의 키를 합하여 전체 개체 수로 나눈 값과 같습니다. 모든 확률분포에 정의된 평균이 있는 것은 아닙니다. 예를 들어 Cauchy 분포입니다.

집단의 표본평균은 집단의 모평균과 다를 수 있으며, 특히 표본크기가 작을수록 경우, 집단의 표본평균과 모평균은 다를 가능성이 높아집니다. 큰 수의 법칙은 표본의 크기가 클수록 집단의 표본평균이 집단의 모평균에 가까울 확률이 높다는 법칙입니다.

출처

표준편차(모표준편차는 $\sigma$, 표본표준편차는 $S$를 기호로 사용)는 데이터 값의 다양성이나 분포를 나타내는 척도입니다. 표준편차가 작다는 것은 데이터 값들이 대략적으로 평균(기대값)에 가까이 분포한다는 것을, 표준편차가 높다는 것은 평균에서 멀리 분포한다는 것을 의미합니다.

확률변수, 통계적 집단, 데이터의 무한집합 또는 확률분포의 모표준편차는 모분산의 제곱근입니다. 절대편차의 평균보다 정확하지는 않지만 수학의 대수적인 면에서 더 간단합니다. 표준편차가 가지는 장점은 분산과 다르게 데이터와 같은 단위를 사용한다는 것입니다.

표준편차는 집단의 분포정도(분산도)를 표현하기 위한다는 것 외에도 통계적 결론에 대한 신뢰도를 측정하는 데에도 사용됩니다. 예를 들어, 투표 데이터의 오류 허용 범위는 투표가 여러번 진행되었을 때 기대되는 표준편차를 계산하여 구하게 됩니다. 이 표준편차의 활용은 추정치의 표준오차, 또는 평균값의 표준 편차라고 부릅니다. 무한한 수의 표본이 추출되고 각 표본의 평균이 계산될 경우 그 집단에서 추출될 수 있는 모든 표본에서 계산되는 표본평균의 표준편차를 표본평균 표집의 모표준편차로 부릅니다. 즉, 표본평균의 표집분포의 표준편차가 통계적 결론(모평균 점추정)에 대한 신뢰도로 나타납니다.

집단의 모표준편차와 집단에서 추출한 표본에서 구한 표본평균의 표준오차는 서로 다르면서도 연관되어 있다는 것(관측 수의 제곱근과 관련됨)이 매우 중요합니다. 관찰된 오류는 표본평균의 표준오차(집단의 모표준편차에 표본크기의 제곱근의 역수를 곱한 것)로 계산되며 일반적으로 95% 신뢰구간의 절반, 표준편차의 약 2배(정확하게는 1.96배)입니다.

과학에서는 많은 연구자들이 실험 데이터의 표준편차를 기록한 후, 기대했던 값보다 표준편차의 2배가 넘게 차이가 났을 때에만 통계적으로 의미있다고 판단해 일반적인 무작위적 오류를 배제합니다. 또한 표준편차는 투자 변동성의 척도를 수익률의 표준편차로 계산되는 것처럼 금융에서도 중요합니다.

집단의 데이터 중 일부만 사용이 가능할 경우, “표준편차의 표본” 또는 “표본표준편차” 이 2가지 표현이 모두 위에서 언급한 양 또는 집단의 모표준편차의 편견없는 기대값을 의미할 수 있습니다.

출처

standard deviation – Wikipedia